做一个有温度和有干货的技术分享作者 —— Qborfy

今天我们来学习 循环网络 RNN

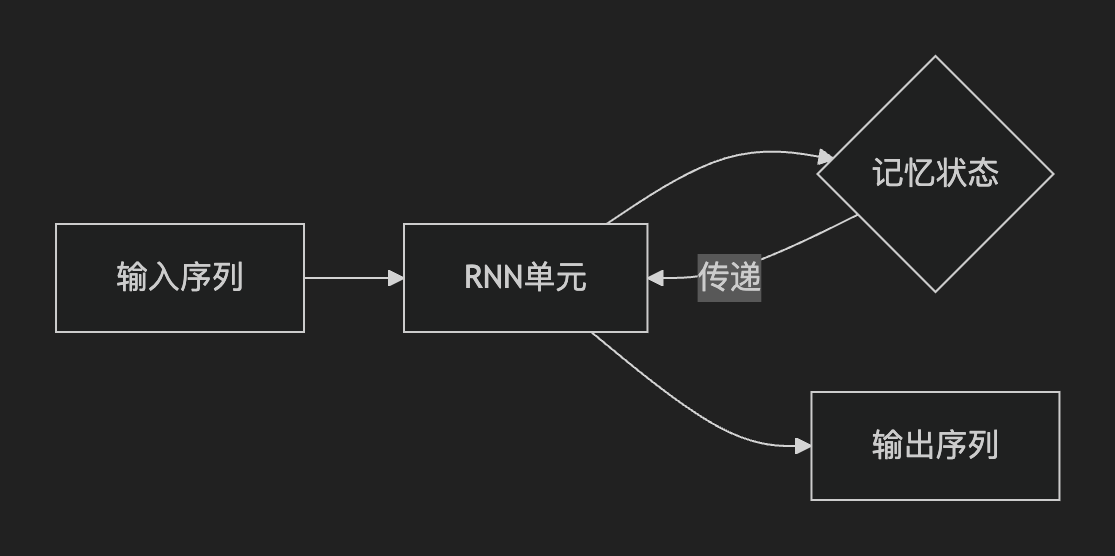

一句话核心: 循环网络 RNN = 带记忆功能的神经网络,通过循环连接保留历史信息,专为处理序列数据(文本、语音、时间序列)而生

是什么

“RNN的循环连接,是AI从静态画像走向动态影像的关键一跃”—— 吴恩达(Andrew Ng)

- 记忆状态:如分拣中心的传送带,持续传递包裹(信息)

- 关键突破:传统神经网络每步独立处理 → RNN利用上一步结果辅助当前决策

关键算法模型

| 模型 | 核心机制 | 创新点 |

|---|---|---|

| LSTM | 三重门控 + 细胞状态 | 遗忘门主动丢弃无用记忆(如清理过期快递) |

| GRU | 两重门控(更新门+重置门) | 合并记忆与隐藏状态,参数比LSTM少25% |

生活化理解:驾校教练 → 根据学员压线距离扣分 → 损失函数就是那套评分标准 → 让学员学会不压线

怎么做

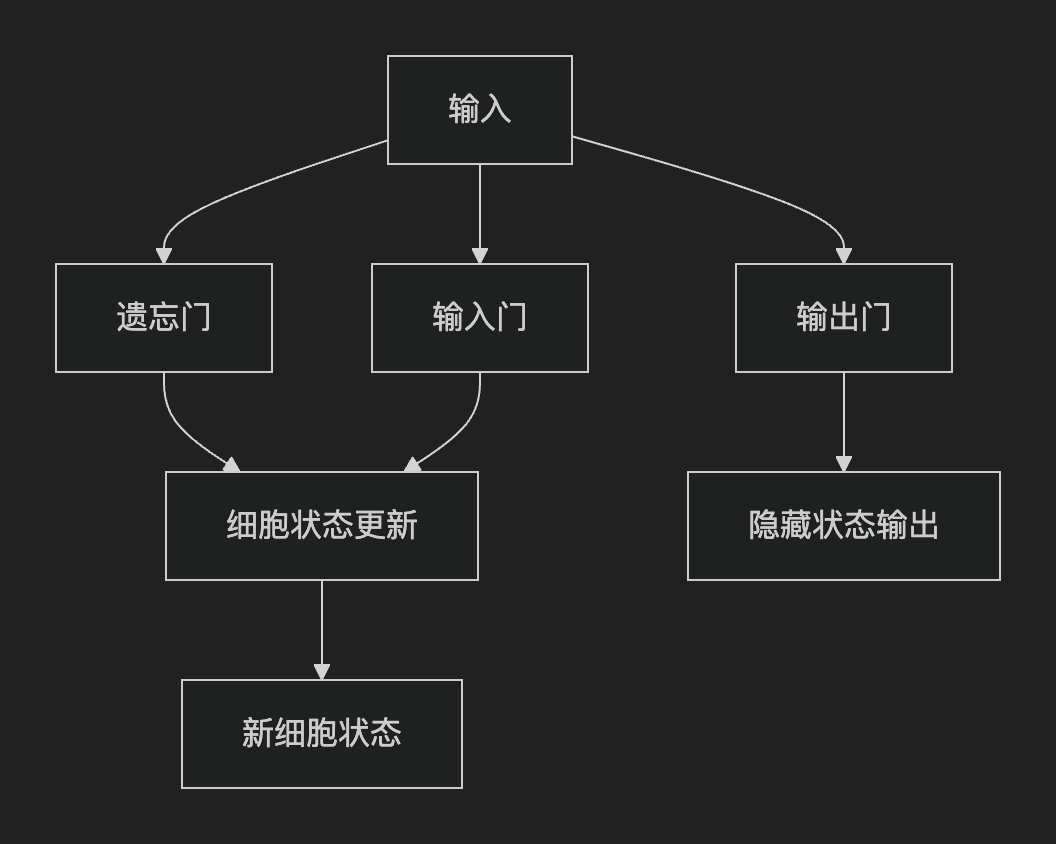

LSTM(长短期记忆网络)

核心目标:解决传统RNN的长期依赖问题(梯度消失/爆炸),通过门控机制选择性保留关键历史信息

结构创新:

- 记忆细胞(Cell State):贯穿时间步的“信息高速公路”,稳定传递长期记忆。

- 三重门控:遗忘门、输入门、输出门动态调控信息流

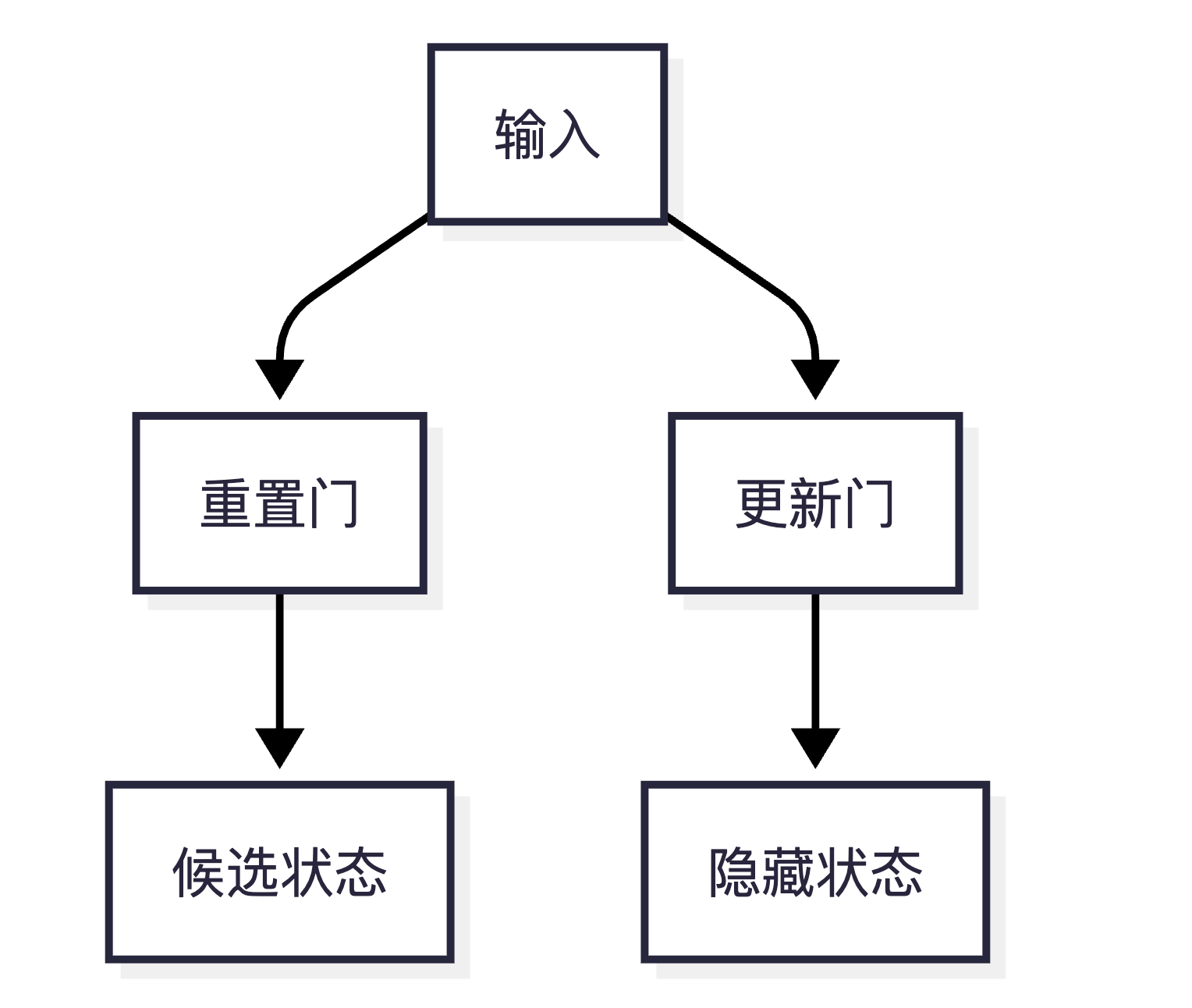

GRU(门控循环单元)

核心目标:在保留LSTM优势的同时简化结构、提升计算效率

结构创新:

- 双门设计:合并遗忘门与输入门为更新门,新增重置门,取消独立记忆细胞。

- 隐藏状态融合:直接操作隐藏状态,参数减少约25%

实际应用

| 任务类型 | 推荐模型 | 案例 | 关键优势 |

|---|---|---|---|

| 实时语音识别 | GRU | 智能音箱指令解析 | 低延迟,参数少 |

| 长文本翻译 | LSTM | ChatGPT早期版本 | 长期依赖捕捉 |

| 股票价格预测 | 双向RNN | 高频交易波动分析 | 结合历史与未来趋势 |

| 视频动作生成 | 堆叠LSTM | 抖音AI跳舞视频 | 多层抽象时序特征 |

冷知识

ImageNet冠军的“陪跑”:

2012年AlexNet夺冠引爆深度学习,而LSTM论文同年发表却无人问津,直至5年后成为NLP基石人脑 vs LSTM 能耗比:

人脑处理一句话耗能≈0.3卡路里,同等任务LSTM耗能≈1.2万倍 —— 但错误率低40%梯度消失的物理隐喻:

RNN梯度消失 ≈ 山洞回声传递:距离越远,声音越微弱,10步后几乎消失工业界的“返祖”现象:

特斯拉自动驾驶放弃Transformer,回归GRU:因实时处理需求更高,GRU比LSTM快37%

- 本文作者: Qborfy

- 本文链接: https://www.qborfy.com/ailearn/daily/09.html

- 版权声明: 本博客所有文章除特别声明外,均采用 MIT 许可协议。转载请注明出处!